Nederland wereldwijd koploper op het gebied van ‘Responsible AI’

Op 13 juni 2024 zijn vanuit het global center for AI Governance de resultaten gepubliceerd van onderzoek naar de volwassenheid van landen wereldwijd in het verantwoord gebruik van Artificiele intelligentie (hierna: Responsible AI): de Global Index Responsible AI (hierna: GIRAI)[1]. In het complete rapport over deze index wordt geconcludeerd dat de wereldwijde vooruitgang naar Responsible AI achter ligt ten opzichte van de snelheid van zowel ontwikkeling als adoptie. Gelukkig is het vlakbij huis beter gesteld met deze volwassenheid: Nederland is namelijk de koploper als het gaat om verantwoorde inzet van AI!

In deze insight lees je wat is er voor nodig is geweest om deze positie te behalen en hoe wij als Nederland deze positie behouden.

Nu eerst: wat is ‘Responsible AI’?

Responsible AI wordt in de GIRAI[1] omschreven als het ontwerp, de ontwikkeling, de inzet en het bestuur van AI op een manier die alle mensenrechten respecteert en beschermt en de principes van AI-ethiek handhaaft in elke fase van de AI-levenscyclus en waardeketen. Het vereist dat alle betrokken actoren in het nationale AI-ecosysteem verantwoordelijkheid nemen voor de menselijke, sociale en milieueffecten van hun beslissingen.

Het verantwoordelijke ontwerp, de inzet en het bestuur van AI zijn – in deze definitie - evenredig aan het doel van het gebruik en voldoen aan de technologische behoeften van de individuen en samenlevingen die het wil dienen.

Dit is ook hoe ik dit zie: verantwoorde inzet vereist dat alle betrokkenen in elke fase van AI-ontwikkeling en -gebruik hun verantwoordelijkheid nemen en tijdig waardeafwegingen maken, zodat het AI-systeem blijft doen waarvoor het is ontwikkeld en waarvoor we het willen inzetten.

Hoe komt Nederland op nummer 1?

Er zijn een veelheid aan initiatieven, beleid en activiteiten. Dit zijn de 4 belangrijkste:

- In Nederland werken publieke en private organisaties samen aan waardevolle AI-oplossingen. Een voorbeeld hiervan is de Nederlandse AI-Coalitie waarin bedrijven, overheden, kennisinstellingen en onderwijsinstellingen samen aan generieke vraagstukken werken om specifieke toepassingsgebieden en sectoren verder te helpen. Dit vormt een goede basis om veilige en inclusieve ontwikkeling te ondersteunen, zeker als het gaat om verantwoorde inzet van AI voor een door overheden. Ook op plekken waar het mis is gegaan, zie ik dat er uitgebreid onderzoek plaatsvindt en verbeteringen worden doorgevoerd om herhaling te voorkomen

- Er is sturing vanuit onze ministeries op het verantwoorde inzetten van algoritmen.

- In Nederland kennen we (op het moment van schrijven) een staatssecretaris voor digitalisering. Hierdoor is er vanuit de politiek coördinatie geweest op digitalisering, waaronder in het specifiek ‘algoritmen’. Er zijn voorbeelden van landen met een minister voor digitale zaken, zowel in Europa (bijvoorbeeld in Griekenland, Luxemburg, Oostenrijk, Polen en Spanje)[2] als daarbuiten zoals Maleisië, Taiwan en Trinidad. In de Verenigde Arabische Emiraten is zelfs sinds 2019 al een minister AI[3].

- Zo zijn er kwartiermakers, bijvoorbeeld bij Min. J&V[4], en is er onder andere een team AI en algoritmen bij Min. BZK met slimme en ambitieuze ambtenaren. Zij hebben onder andere gewerkt aan het implementatiekader algoritmen, de adoptie van het IAMA-instrument en het landelijke algoritmeregister.

- In 2021 is de interbestuurlijke datastrategie aangeboden, een resultaat van nauwe samenwerking tussen departementen, uitvoeringsorganisaties en koepels van gemeenten, provincies en waterschappen. Vanaf 2022 vinden activiteiten plaats om de genoemde ambities te realiseren.[5] Er is geen specifieke AI- strategie, maar wel een strategisch actieplan voor AI[6] d.d. oktober 2019.

- In de uitvoer is bewezen dat ook de overheid op transparantie en toegankelijke wijze beleid kan ontwikkelen en uitvoeren. Dit is bijvoorbeeld terug te zien in de open source werkwijze bij de ontwikkeling van het landelijke algoritmeregister en de bereidheid om mee te werken aan publicatie in dit register.

- Bij centrale, lokale overheden en uitvoeringsorganisaties is aan processen gewerkt om onder andere het algoritmegebruik in kaart te brengen en algoritmerisico’s te signaleren en te mitigeren alsook hierover te communiceren.

Dit alles is een begin om trots op te zijn, maar er is in de praktijk nog veel werk aan de winkel. Voor een deel van de processen is het namelijk niet gelijk duidelijk dat er algoritmen worden gebruikt. Ook zie ik dat het bewustzijn en kennis over algoritmen en AI nog (te) beperkt is tot een aantal personen – vaak geen beslissers - en er regelmatig te weinig capaciteit is naast reguliere werkzaamheden om bijvoorbeeld gestructureerd algoritmen te identificeren, beoordelen en publiceren.

De werelwijde index voor Responsible AI uitgelegd

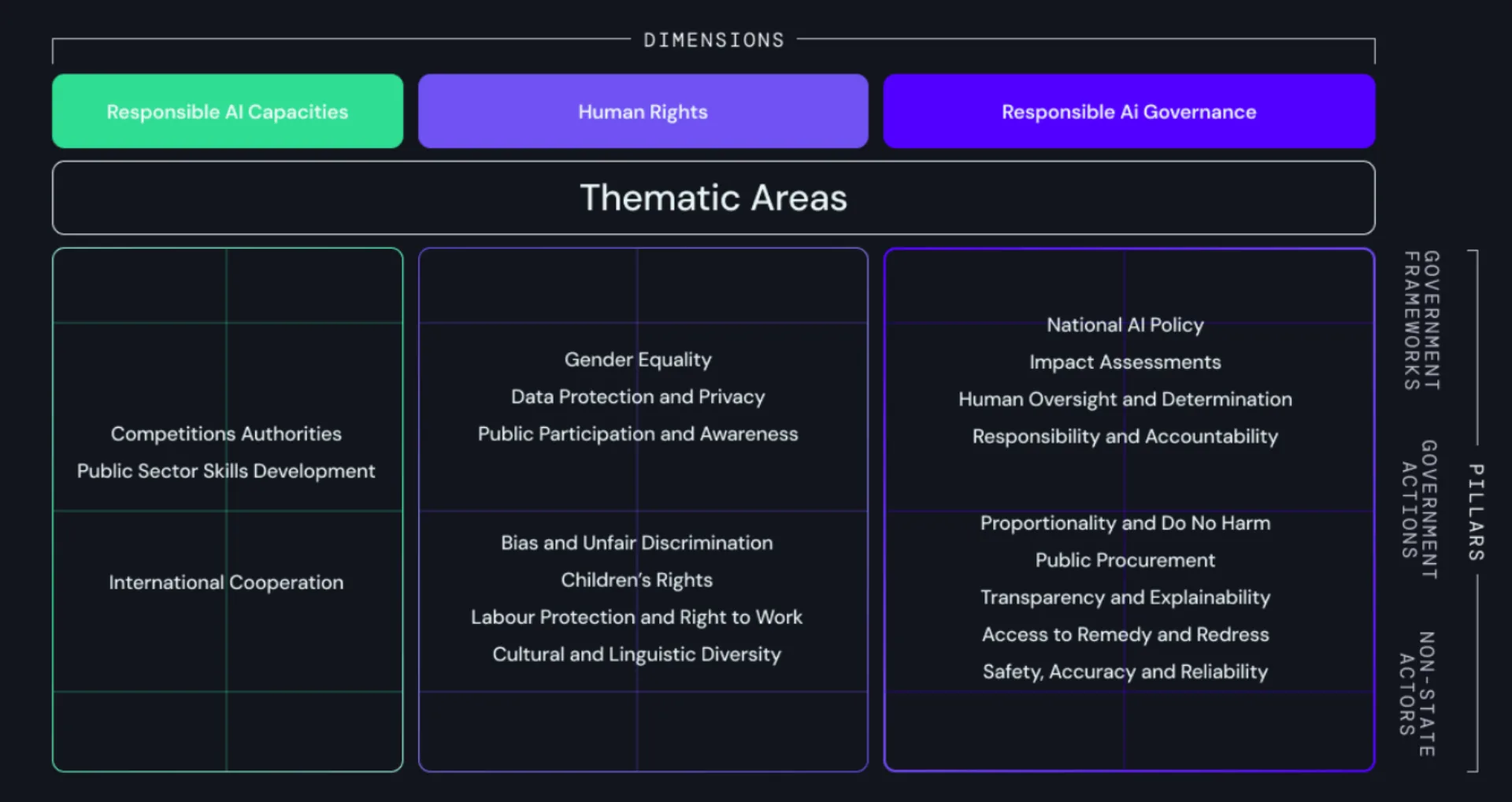

In 138 landen zijn door lokale onderzoekers meer dan 1800 vragen beantwoord. Samen verzamelden ze ruim 2 miljoen datapunten, die vervolgens geanalyseerd zijn door een scala aan gerenommeerde wetenschappers en organisaties. De GIRAI is gemeten over 19 thema’s van verantwoord gebruik, geclusterd over drie dimensies: Mensenrechten en AI, Governance voor verantwoorde inzet van AI en Bekwaamheden in verantwoorde inzet van AI. Binnen elk thema worden de prestaties over drie assen (pillars) van het ecosysteem gemeten, namelijk government frameworks, activiteiten van overheden en marktinitiatieven.[7] Zie figuur 1 hieronder voor een schematische weergave.

De GIRAI scores zijn afgeleid van de primaire data verzameld over de drie assen. Elk thema is op elke as gescored met een waarde tussen 0 en 100 om het gemiddelde per thema en het gemiddelde per as te berekenen.

In de tabel[8] hieronder is te zien dat Nederland voornamelijk nog van Ierland kan leren als het gaat om frameworks en mensenrechten. Op onderdelen (zowel overheid als privaat) en bekwaamheid scoort Nederland erg goed. In de volgende alinea's ga ik dieper in op deze scores per dimensie en wat we kunnen leren van Ierland en Duitsland. Daarna lees je meer over onze grootste uitdagingen en waar je vandaag nog mee kunt beginnen.

Mensenrechten en AI

In het kader van ‘mensenrechten en AI’ heeft de Utrecht data school een instrument ontwikkeld genaamd: de Impact Assessment Mensenrechten en Algoritmen (IAMA). Het gebruik hiervan wordt door de Nederlandse overheid aangemoedigd en geeft invulling om tijdig stil te kunnen staan bij het raken van mensenrechten voordat een algoritme wordt ingezet. Ondanks dat dit instrument vrij uitgebreid is, zijn dit essentiële vragen om tijdens elke fase in de AI-levenscyclus bij stil te staan.

Daarnaast bevat het implementatiekader ‘Verantwoord inzet van algoritmen’ een overzicht van de belangrijkste normen en maatregelen bij de ontwikkeling en implementatie van algoritmen om overheden te ondersteunen bij verantwoorde inzet.

Waarom scoort Ierland beter op mensenrechten en AI?

Met het benoemen van activiteiten in een roadmap gaat Ierland verder dan de richtlijnen en instrumenten vanuit/via de Nederlandse overheid. Ierland heeft in 2021 een AI strategie[9] gepubliceerd waarin de hoofdfocus ligt op mensenrechten en ethische principes. In juni 2023 heeft Ierland de AI Standards & Assurance Roadmap[10] gepubliceerd met daarin de benodigde acties en randvoorwaarden voor het implementeren van de AI act in Ierland. In deze roadmap worden onder andere AI-veiligheid en de nauwkeurigheid en betrouwbaarheid van AI-systemen behandeld. Hierin wordt het belang van AI-normen bij het aanpakken van vragen over veiligheid, rechtvaardigheid, betrouwbaarheid, verantwoording en transparantie onderstreept. Nederland heeft er voor gekozen om drie sporen naast elkaar te zetten waardoor er in vergelijking met Ierland meer nadruk lijkt te liggen op de kansen die AI kan bieden.

Hoe kunnen we het als Nederland beter doen? Maak instrumenten integraal

Mijn advies zou zijn om in elke fase een deel van de vragen uit de IAMA te beantwoorden en/of aan te vullen als integraal onderdeel van de ontwikkeling en inkoop van nieuwe IT-oplossingen bij algoritmen. Alsmede voor het voldoen aan de normen in het implementatiekader: zijn er maatregelen genomen en wanneer is hier aan voldaan?

Bijvoorbeeld door een deel van de informatie uit een BIO en/of DPIA op te halen en alleen extra vragen te stellen voor beide assessments. Vergeet uiteraard niet voor elk AI-systeem de beoordelingen goed vast te leggen en bij ‘hoog risico’- AI-systemen een hoge evaluatie frequentie aan te houden.

Responsible AI Governance

Mijn verwachting is dat er genoeg aan landelijk beleid ligt om echt aan de slag te gaan en niet te blijven hangen in het doorontwikkelen van frameworks en kaders. Ga (samen) aan de slag en ervaar en leer hoe je bestaande frameworks en kaders kan aansluiten op de praktijk. Pas de governance periodiek aan op veranderingen en het geleerde. Misschien kunnen we hiermee Duitsland verslaan...?

Waarom scoort Duitsland beter op de governance-as?

Ondanks dat er veel is uitgewerkt scoort Duitsland op het gebied van Responsible AI Governance hoger. Het is mij niet exact bekend op welk onderdeel Duitsland exact beter gescoord heeft in vergelijking met het Nederlandse beleid op AI governance. Duitsland was er uit deze top 3 het eerst bij met een AI strategie[11] in 2018 en een herziening[12] in 2020. Deze herziening geeft invulling aan een belangrijk element uit een goede governance, namelijk: continu leren.

Bekwaamheden in verantwoorde inzet van AI

Door de intensieve samenwerking tussen publieke en private organisaties, is door de overheid zowel inhoudelijke als externe kennis betrokken om de uitdagingen rondom AI aan te kunnen pakken en dat vertaalt zich naar een uitmuntende score op deze dimensie.

Echter, met de komst van algemeen beschikbare taalmodellen, bijvoorbeeld door ChatGPT, merk ik dat iedereen ineens iets lijkt te weten van AI of zelfs beweert er alles van te weten. Ja, het is inderdaad toegankelijker, maar is het echt zo dat iedereen er goed mee kan werken? Dat is natuurlijk niet het geval, het gaat nog vaak over ‘spelen met’. We hebben wat dat betreft nog veel stappen te maken om de ‘onbewust onbekwamen’ te helpen naar een volgende volwassenheidsniveau.

Laten we de kennis van experts gebruiken om deze stappen te maken. Voor organisaties betekent dit werken aan brede awareness over beleid, kansen en risico’s omtrent algoritmen in alle lagen van de organisaties, ook in het management.

Samen blijven verbeteren:

Zoals het GIRAI-rapport dan ook terecht schetst, is AI governance alleen niet voldoende. In de GIRAI 2024 is de mate waarin AI-systemen ontworpen en ingezet worden binnen de kaders van verantwoorde AI gebruik niet gemeten. Met de status van de AI governance in Nederland is er zeker een gedegen basis voor Responsible AI.

Echter, moet in de praktijk nog wel gestructureerd uitvoering aan deze governance gegeven worden. Het Global Center doet een oproep aan iedere overheidsorganisatie of -orgaan voor het nemen van specifiekere maatregelen met betrekking tot mensenrechten. Zij adviseren om te starten vanuit duidelijk beleid en het geven van goede voorbeelden. Om samen scherp te blijven op de vooruitgang in de praktijk, zullen alle actoren hierin hun verantwoordelijkheid moeten nemen. Maar hoe pas je Responsible AI concreet toe in de praktijk?

Onze uitdagingen in de praktijk

In het kort geeft het Global Center twee aanbeveling aan landen met een hoge GIRAI om zich internationaal in te zetten voor het verkleinen van de toegankelijkheid tot (Responsible) AI en het adopteren van wet- en regelgeving voor het borgen van mensenrechten. Met de komst van de AI Act en de goede basis aan governance is het een kleine stap om deze wet-en regelgeving daadwerkelijk te adopteren. Maar hoe begin je met deze adoptie?

In de praktijk merk ik dat er inderdaad nog veel vragen leven over wat het landelijke algoritmebeleid nu precies betekent voor specifieke organisaties en waar de daadwerkelijke adoptie plaatsvindt. Denk hierbij aan vragen zoals: Hoe krijg ik inzichtelijk welke algoritmen mijn organisatie gebruikt? Hoe zorg ik dat ik aansluit op het algoritmeregister? Waar kan ik AI nog meer voor inzetten? Hoe blijf ik in controle van mijn AI-systemen en algoritmen? Wie heb ik daarvoor nodig en wie is verantwoordelijk?

Start vandaag om in 2026 (en eerder!) volledig verantwoord AI in te zetten

Vertaal het landelijke beleid naar wat dit betekent voor jouw organisatie en geef antwoord aan de praktische vragen over AI en algoritmen in jouw organisatie. Dit kan door het aanscherpen van eigen beleid, bepalen van doelstellingen en het inregelen van processen en borgen van verantwoordelijkheden. Vind hierbij niet het wiel uit, maar sluit aan bij bestaande governances zoals ICT, data, privacy en informatiebeveiliging.

Start bijvoorbeeld met het implementeren van een AI management systeem, zoals ISO42001. Dit is een gestructureerde manier om AI-beleid en doelstellingen vast te stellen, alsmede het opstellen, inrichten, uitvoeren en evalueren van de processen om die doelstellingen te bereiken.

Hiermee heb je gelijk een standaard te pakken om gestructureerd in controle te zijn van AI-systemen (en algoritmen). Bovendien kun je hiermee, naast het hanteren van een gestructureerde werkwijze, ook gelijk aantonen te voldoen aan een aantal van de verplichtingen uit de AI Act, zoals compleet beeld van AI-systemen in gebruik en processen voor o.a. risicoclassificatie, -beoordeling en maatregelen, impactanalyses en transparantie. Aan deze verplichtingen zullen organisaties, die hoog risico AI-systemen gebruiken, al in 2026 moeten voldoen.

Bronnen

[3] https://www.computable.nl/2019/01/25/emiraten-zijn-rolmodel-voor-ai-en-ethiek/

[5] https://www.digitaleoverheid.nl/interbestuurlijke-datastrategie/

[6] https://open.overheid.nl/documenten/ronl-e14cdcee-690c-4995-9870-fa4141319d6f/pdf

[8] https://global-index.ai/Countries

[10] https://www.nsai.ie/images/uploads/general/NSAI_AI_report_digital.pdf

Gerelateerde inzichten